Các mô hình AI 'hình ảnh' thực sự mù mịt?

Các mô hình ngôn ngữ mới nhất, như GPT-4o và Gemini 1.5 Pro, được quảng cáo là 'đa phương tiện', có khả năng hiểu hình ảnh và âm thanh cũng như văn bản — nhưng một nghiên cứu mới làm rõ rằng chúng thực sự không nhìn theo cách mà bạn có thể mong đợi. Trên thực tế, chúng có thể không nhìn chút nào.

Rõ ràng từ đầu, không ai đã đưa ra những tuyên bố như 'AI này có thể nhìn giống như con người!' (Nhưng có lẽ có một số người. ) Nhưng các chiến dịch tiếp thị và các tiêu chí được sử dụng để quảng cáo các mô hình này sử dụng các cụm từ như 'khả năng thị giác', 'hiểu thị giác', và vân vân. Họ nói về cách mô hình nhìn và phân tích hình ảnh và video, để chúng có thể làm bất cứ điều gì từ việc làm bài tập về nhà đến xem trận đấu cho bạn.

Vì vậy, mặc dù các yêu cầu của các công ty này đều được diễn đạt một cách tinh tế, nhưng rõ ràng họ muốn biểu hiện rằng mô hình nhìn theo một cách nào đó. Và nó có — nhưng có thể nói cách khác giống như cách nó thực hiện toán học hoặc viết truyện: khớp các mẫu trong dữ liệu đầu vào với các mẫu trong dữ liệu huấn luyện của nó. Điều này dẫn đến các mô hình thất bại cách họ làm trên một số nhiệm vụ khác có vẻ đơn giản, như chọn một con số ngẫu nhiên.

Một nghiên cứu — không chính thức theo một số cách, nhưng có hệ thống — về việc hiểu thị giác của các mô hình AI hiện tại đã được thực hiện bởi các nhà nghiên cứu tại Đại học Auburn và Đại học Alberta. Họ đưa ra cho các mô hình đa phương tiện lớn nhất một loạt các nhiệm vụ thị giác rất đơn giản, như hỏi xem hai hình dạng có chồng lên nhau hay không, hoặc có bao nhiêu ngũ giác trong hình ảnh, hoặc chữ cái nào trong một từ được đánh vòng. (Bạn có thể xem tóm tắt trang riêng tại đây.)

Đó là những điều mà một học sinh lớp một cũng sẽ làm đúng, nhưng mà các mô hình AI gặp khó khăn lớn.

'7 nhiệm vụ của chúng tôi rất đơn giản, với con người sẽ thực hiện với độ chính xác 100%. Chúng tôi mong đợi AI làm tương tự, nhưng hiện tại họ không làm được,' đồng tác giả Anh Nguyen viết trong một email gửi tới TechCrunch. 'Thông điệp của chúng tôi là 'nhìn, những mô hình tốt nhất vẫn đang thất bại.' "

Hãy xem nhiệm vụ về các hình dạng chồng lên nhau: một trong những nhiệm vụ lý thuyết thị giác dễ nhất có thể tưởng tượng được. Khi được trình bày với hai hình tròn chồng nhau một cách ít nhiều, chỉ chạm nhẹ hoặc cách nhau một số, các mô hình không thể đều đặn làm đúng. Chắc chắn, GPT-4o làm đúng hơn 95% trong trường hợp chúng xa nhau, nhưng ở khoảng cách gần 0 hoặc nhỏ, chỉ đúng 18% lần! Gemini Pro 1.5 làm tốt nhất, nhưng vẫn chỉ đạt 7/10 ở khoảng cách gần.

(Các hình minh họa không thể hiện chính xác hiệu suất của các mô hình, nhưng được thiết kế để cho thấy sự không nhất quán của các mô hình qua các điều kiện. Những số liệu cho mỗi mô hình đều có trong bài báo.)

Hoặc là tính số lượng vòng tròn nối liền trong hình ảnh? Tôi sẽ đặt cược rằng một con ngựa trung bình có thể làm được điều này.

Chúng đều làm đúng 100% thời gian khi có 5 vòng — công việc tuyệt vời của AI thị giác! Nhưng sau đó thêm một vòng khiến kết quả tan hoang hoàn toàn. Gemini lạc lõng, không thể làm đúng một lần nào. Sonnet-3.5 trả lời 6… một phần ba thời gian, và GPT-4o một chút dưới một nửa thời gian. Thêm một vòng làm cho việc này càng khó, nhưng thêm một vòng làm cho nó dễ dàng hơn với một số mô hình.

Điểm của thí nghiệm này đơn giản chỉ là để cho thấy rằng, bất kể các mô hình này đang làm gì, thì thực sự không tương ứng với điều chúng ta nghĩ với từ 'nhìn'. Sau cùng, ngay cả khi chúng nhìn kém, chúng ta không giả định rằng hình ảnh với 6, 7, 8, và 9 vòng sẽ thay đổi rộng rãi về thành công.

Các nhiệm vụ khác được thử nghiệm cho thấy các mô hình không phải là đã nhìn hay suy luận tốt hoặc tồi, nhưng dường như có một lý do khác tại sao họ có thể đếm trong một trường hợp nhưng không phải trường hợp khác.

Một câu trả lời tiềm năng, dĩ nhiên, đang ở trước mắt chúng tôi: tại sao họ lại tốt đến vậy khi làm đúng một hình ảnh 5 vòng, nhưng thất bại thảm hại như vậy trên phần còn lại, hoặc khi có 5 ngũ giác? (Để công bằng, Sonnet-3.5 làm khá tốt đối với điều đó.) Bởi vì tất cả đều có một hình ảnh 5 vòng được nổi bật trong dữ liệu huấn luyện của họ: Biểu tượng Olympic.

Biểu tượng này không chỉ được lặp đi lặp lại trong dữ liệu huấn luyện mà còn có khả năng được mô tả chi tiết trong văn bản thay thế, hướng dẫn sử dụng và các bài báo về nó. Nhưng nơi nào trong dữ liệu huấn luyện của họ bạn sẽ tìm thấy 6 vòng nối liền, hoặc 7? Nếu các phản ứng của họ là một dấu hiệu… không đâu! Họ không biết họ đang 'nhìn' cái gì, và không có sự hiểu biết hình ảnh thực sự về các vòng, sự chồng chéo, hoặc bất kỳ khái niệm nào khác.

Tôi hỏi các nhà nghiên cứu họ nghĩ gì về 'mù mờ' mà họ buộc tội các mô hình có. Giống như các thuật ngữ khác chúng ta sử dụng, nó có một chất nhân bản con người không hoàn toàn chính xác nhưng khó tránh khỏi.

'Tôi đồng ý, "mù" có nhiều định nghĩa ngay cả đối với con người và vẫn chưa có một từ để mô tả kiểu mù hoặc vô cảm này của các mô hình AI đối với các hình ảnh mà chúng ta đang hiển thị,' Nguyen viết. 'Hiện tại, không có công nghệ nào để minh họa đúng chính xác những gì một mô hình đang nhìn thấy. Và hành vi của họ là một hàm phức tạp của câu hỏi văn bản đầu vào, hình ảnh đầu vào và hàng tỷ trọng số.'

Ông phỏng đoán rằng các mô hình không phải là hoàn toàn mù mờ nhưng thông tin hình ảnh chúng trích xuất từ một hình ảnh là xấp xỉ và trừu tượng, một cái gì đó như 'có một hình tròn ở phía bên trái.' Nhưng các mô hình không có cách nào làm ra những đánh giá hình ảnh, khiến các phản ứng của họ giống như của một người được thông tin về một hình ảnh nhưng không thực sự nhìn thấy nó.

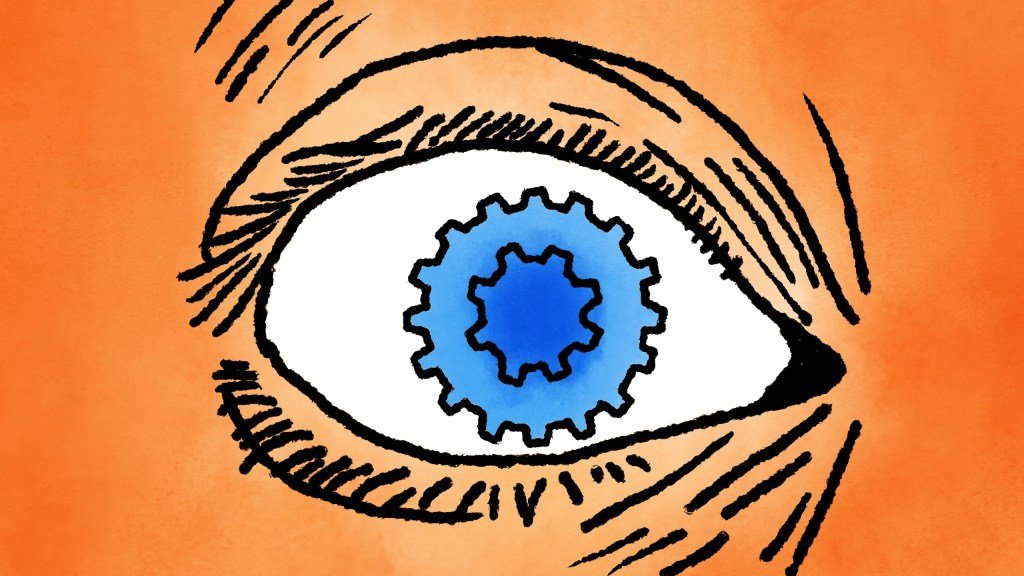

Là một ví dụ cuối cùng, Nguyen gửi đây, hỗ trợ cho giả thuyết trên:

Khi một hình tròn màu xanh lá cây và một hình tròn màu xanh lam chồng lên nhau (như câu hỏi yêu cầu mô hình xem như sự thật), thường có một khu vực bị xám làm mát, như trong biểu đồ Venn. Nếu ai đó hỏi bạn điều này, bạn hoặc bất kỳ người thông minh nào đều có thể đưa ra cùng một câu trả lời, vì nó hoàn toàn có thể... nếu mắt bạn đóng! Nhưng không ai với mắt mở sẽ đáp như vậy.

Tất cả điều này có nghĩa là các mô hình AI 'hình ảnh' này vô ích không? Chưa đến nỗi đó. Không thể làm lý do cơ bản về một số hình ảnh cụ thể mặc dù nói lên khả năng cơ bản của chúng, nhưng không phải khả năng cụ thể. Mỗi mô hình này có khả năng cao sẽ rất chính xác về các hành động và biểu cảm của con người, hình ảnh của các đối tượng và tình huống hàng ngày, và vân vân. Và thực sự đó là điều mà chúng được dự định để hiểu.

Nếu chúng ta dựa vào chiến dịch tiếp thị của các công ty AI để cho chúng ta biết mọi thứ mà các mô hình này có thể làm, chúng ta sẽ nghĩ rằng chúng có tầm nhìn 20/20. Cần có nghiên cứu như thế này để cho thấy rằng, dù mô hình có chính xác đến đâu trong việc nói xem một người đang ngồi hay đi bộ hay chạy, họ làm điều đó mà không 'nhìn' theo nghĩa (nếu được phép) mà chúng ta thường hiểu.